无极主管_对话Epic音频专家,MetaSounds 如何改变VR、AR体验

音频程序化,创作开放化。

在 12 月 3 日举办的虚幻引擎技术开放日中,Epic Games 首席音频程序员 Aaron McLern 带来了《MetaSounds:虚幻引擎5次时代音效系统》主题分享,将全开放性的音频制作系统接入到了虚幻引擎5中。

MetaSounds可以让用户全面控制音源的音频 DSP 图表生成,管理音频渲染的各个方面,赋能深度创作。它好比一条完全可程控的材质和渲染管线,将材质编辑器为着色器实现的所有程序化内容创建的优点都带到了音频领域:动态的数据驱动资源,将游戏参数映射到声音播放的功能……

作为虚幻引擎5最重磅的一个功能增加,MetaSounds 在给予创作者音频高度自由化支持的同时,也让整个虚幻引擎朝着更加高度集成的开放式创作平台迈进了一步。会后,Aaron McLern也与 VR 陀螺围绕“音频系统流程、功能特性、未来发展”等问题进行了简短的线上交流。

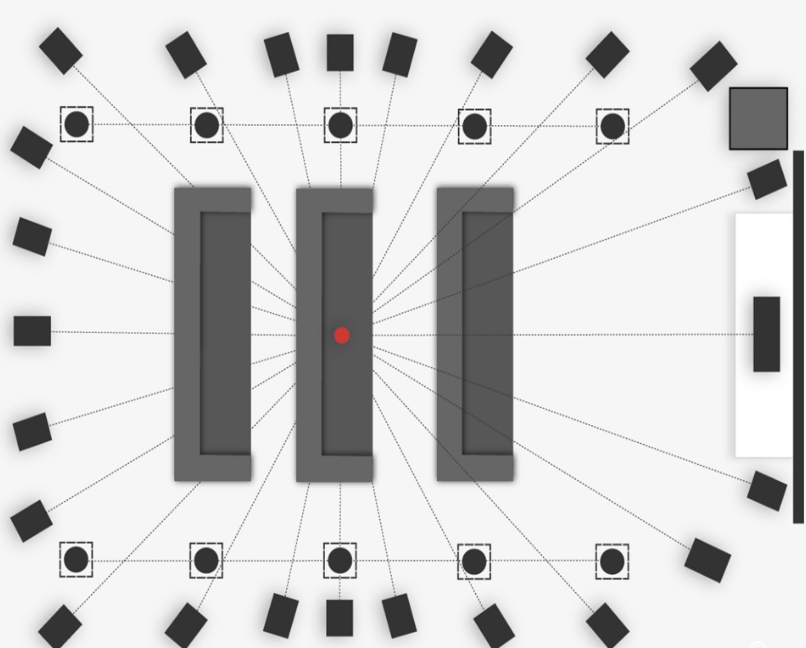

图源:VR陀螺

Q&A

一、在“mini guns to music”的视频中展示了虚幻引擎5的 Metasounds 音频系统,通过可视化路径来设置音效的实现,请问使用 Metasounds 相比之前的音频工具,游戏中的音效设计,对于工作流程和效率以及最终实现的效果具体带来了哪些提升呢?

首先,MetaSounds 会直接渲染它们的音频,而不是发送高级参数来控制声音文件的播放效果,MetaSounds 允许你直接对原生的程序化音频数据进行塑造和调整 。

实现任意以及精准的计时(我们称之为 ”采样级精准“),这意味着你可以通过节点图表的方式来定义逻辑并直接控制 DSP。换句话说,它将音频生成的方式从固定音频渲染管线变成了一种完全可编程的管线。从这个角度来说,它有点类似于虚幻引擎中的材质图表——一种图形化的着色器,允许你直接控制数学运算以生成程序化材质。在材质着色器出现前,图形渲染主要利用固定渲染管线,其灵活性有限,导致开发创意往往受到硬件及时间成本的限制。

如果你把声音文件比作一张纹理,你可以把传统的音频渲染方法类比成绘制一些随机选中的纹理(有时这些纹理会混合在一起),然后你有一些功能有限的高级参数,用来对纹理进行操作(比如调整亮度、颜色等)。显然,你在图形渲染中能做的应该远远不止这些。对于音频来说,在传统管线中,就像是随机选择一些声音文件,然后设置一些写死的高级参数,例如响度、音高、滤波器等。

MetaSounds 目前支持合成(即在 MetaSounds 中嵌套 MetaSounds)以及预设,所以,和虚幻引擎中的材质一样,你也能够复用其拓扑结构,开发者可以分享其音效图表逻辑。我预测在大型项目中,团队一般都需要建立一些 MetaSounds 资产库。就《堡垒之夜》而言,我们预计最终需要二十几个 MetaSounds 来配合目前使用的上千个音频资产。

我们还希望在 MetaSounds 的“域”上进行扩展,允许渲染 DSP 处理效果,这样它们就能被用来作为混响器、空间器,而不仅仅是生成音效。 此外,MetaSounds 在底层设计上允许其向第三方内容扩展。换句话说,我们期待看到更多创新性的第三方库,能在 MetaSounds 的基础上进行功能扩展。

最后,或许也是最重要的一点——MetaSounds 在设计之初就极具前瞻性,特别是在新媒体体验方面。我们希望看到,今后由某款应用或游戏创建的 MetaSounds 可以轻松地在另一款应用/游戏中渲染;我们希望 MetaSounds 拥有完善的接口来指明其需要的输入参数,并且包含所有需要的信息,以便在任何游戏玩法系统中渲染。未来的趋势就是互操作性和数据共享,而正如其名中的蕴意,我们希望 MetaSounds 能成为这种趋势的引领者。

Aaron McLern

二、由于我们专注于 XR 产业,所以想跟您请教一些关于 VR、AR 中的声音实现问题。首先,现在 Metasounds 已经实现了对 PC 端和移动端的 VR、AR 终端的支持吗?在这个方向上,大概的规划是怎样的?

MetaSounds 能在虚幻引擎中开箱即用,它用到了声源之前能用到的所有旧功能,包括所有现有的空间化插件、DSP 效果处理、距离衰减、声音并发组等。MetaSounds 只是在源音频输出的方式上进行了创新,但它们仍能和我们的所有已有系统一起工作,这意味着它能在所有 XR 平台上开箱即用。

唯一的瓶颈是(这种瓶颈在其他系统中也很常见),你需要注意 CPU 的使用情况。MetaSounds 尽管很强大,但目前仍无法很好地反映 CPU 的占用情况(我们正在开发一些功能,让用户更好地了解 CPU 的利用率和开销预算),所以 CPU 的开销很容易过头。好消息是,MetaSounds 兼容我们现有的所有性能分析工具(如 Unreal Insights),所以你仍能查看 MetaSounds 给 CPU 带来的影响,只不过对音效设计师来说,操作上仍有些不直观。

三、VR中的音效实现,现在比较常用的是“3D 全景声”,也有诸多在这个领域上探索的公司,比如瑞典的Dirac,现对于传统的5.1或7.1声场效果,全景声必须实现720度各角度、各个点位的精准声音模拟,就像真实环境中的物理音效一般,您认为现如今的技术要实现完全逼真的全景声是可行的吗?技术难点主要是什么呢?

我不是很清楚什么是 “3D 全景声(3D Panoramic Sound)” 。我猜可能是“声场(sound field)”渲染技术的另一种说法。我们打算通过 MetaSounds 来实现多声道音频的完全支持,并对声道无关的音频渲染技术(即声场渲染、基于对象的渲染等)实现一些更强大的支持。

话说回来,我们在虚幻引擎中已经支持了这个技术(指声场),并在虚幻引擎 5 的发布演示(即 Lumen in the land of Nanite)中用到了它。最初,该演示打算在 GDC (游戏开发者大会)的环绕声影院中现场播放,以便充分展示声场渲染的效果。但由于疫情爆发,GDC 取消, 我们不得不做成演示视频,这肯定无法充分展现声场渲染的真正效果。

图源:网络

四、据了解目前主流的音频技术是静态HRTFs技术,但是HRTFs随声源的相对位置、频率和听觉对象不同而变化,并与其自变量之间存在非常复杂的非线性关系,所以3D全景声的实现需要处理庞大的HRTFs数据,因此有公司提出了动态HRTFs,您如何看待这项技术,从引擎端是否有更好的解决方案?

我们目前没有 HRTF 渲染相关的研发计划,未来可能会有,但眼下我们主要是完善针对第三方的空间化接口,允许第三方尝试空间渲染技术。我们正与该领域的所有主要参与者和一些初创公司合作。我们也欢迎开发者修改我们的 API 以实现新技术。在这个 领域(HRTF)有一大堆投资和创业公司,考虑到我们有大量核心音频渲染技术(比如MetaSounds)亟需研发,再去投资该领域(HRTF)意义不大。

五、声音包含输入和输出两端:

①输入的采集方式包含基于真实场景的收音和使用引擎制作的模拟声场,这两种方式您更推荐哪种,哪种能实现更好的效果?

②在输出端根据硬件设备不同,所能够体验到的效果也会差距甚远,如适用于影院的杜比全景声最多有64个独立扬声器呈现内容,且多达 128 个音轨。如果是在普通的电子消费终端(如VR设备上),怎样才能用最低的价格实现高质量的声音体验?这个矛盾是否能通过软件技术解决?

交互式音频(也就是游戏音频)很难用一种包罗万象、适用于任何人和任何情况的方式来概括描述。我认为最好是先确定音频引擎可以支持的所有功能、音频在游戏中如何实现(即数据如何挂接到程序化系统),以及有哪些技术可以用于收集原始素材。确定好这些问题后,再考虑使用哪种方法来生成资产和输入。

总体上说,我习惯把音频领域和美术中的图形领域进行类比,这种思考方式能让我们以更加实际的方式考虑内容生产,避免过度简单化。图形领域显然更加复杂,需要许多配套技术、领域和专业人员同时协作,共同实现整体的视觉效果。音频也应当需要这样的资源投入,但一般来说不必这么复杂。举例来说,音效师通常应该这样规划职业:专职为环境设计音频(环境音频设计师)、或为粒子特效设计音频(粒子特效音频设计师)、或为角色设计声音和系统(角色音频设计师)等等。不过,相比视觉艺术领域中大多数的各司其职,音频有一个特有的复杂领域:音乐。

音频渲染器输出应该尽可能和软件解耦,我个人对于完全使用硬件和基于平台的解决方案持观望态度。相较于图形领域而言,音频的好处是对硬件依赖较低。图形基本依赖于显卡工作,因此和相关硬件制造商密不可分。幸运的是,目前音频可以完全在常用 CPU 上运算。目前,某些运算在硬件加速方面(比如加速卷积)方面也取得了很大进展,我非常支持这一点,只要这种运算是普遍的,并且能够在保证相同输出的情况下使用软件和 CPU 解决方案。至于输出渲染的空间格式,它们关系到扬声器声道数目、排列、收听环境等等。

现在,硬件制造商(杜比、DTS、THX 等)在这个方面已经取得了非常棒的成果。这也是“基于对象的”音频渲染的发展方向,而在此处,游戏会提供音频流和空间位置元数据,硬件制造商将该数据在本地映射至给定的设置。想在音频引擎中处理这种量级的复杂度是不可能的:它不可持续,也不可扩展。

理论上说,音频引擎会在基于对象的音频流或者无关声道的、可以解码至任意输出配置的声场中进行所有音频的渲染。这两种方式允许音频渲染无关输出,并且硬件制造商可以在本地计算机上进行解码和映射,以便找到最适配给定硬件的设置。

图源:网络

这一过程可能是通过分析使用麦克风阵列的空间进行的。如果电影(或者交互式电影/游戏)云渲染可以尽可能包含在无关声道格式中能够包含的所有音频信息,当指定听众在网上进行流播时,可以智能映射至本地硬件设置(耳机、条形音响、环绕音响等等),这对于沉浸式体验来说将是一种最为理想的方式。

同时,这种方式也能为玩家流播游戏提供强力的支持,也就是说,玩家可以从游戏中提取无关声道格式的音频,然后播送至直播流,并以最佳的音质解码到听众的本地环境中。

在这个理想化的场景中,唯一的难点是混合 DSP 效果——也就是在混合声源的缓冲区上进行的音频处理。游戏和影视中使用的许多强大音频工具——例如动态处理(压缩等),均衡(平衡游戏的声谱),以及混响处理(模拟空间)——都离不开混合 DSP 效果。

目前,所有这些效果都是通过基于通道的音频格式完成的。没有一种很好的方法来借助声道无关的声场来实现这种效果处理——也就是不需要解码到虚拟扬声器/声道,执行基于声道的处理,然后再重新编码到声场表示。虽说这种方法可行,但你肯定会丢失一些原始声场的空间真实性。这绝对是一个值得研究的领域,我也相信未来 10 年内一定会有所突破。

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 西瓜(微信 18659030320) 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

版权申明:本文经原作者授权发布,不代表VR陀螺立场,如需转载请直接联系原作者